Nástroje na zpracování přirozeného jazyka, jako je ChatGPT, navždy mění obsah bezpečnostních školení. Ale jak se koncoví uživatelé dozvědí, co už nebude fungovat?

Nástroje na zpracování přirozeného jazyka, jako je ChatGPT, navždy mění obsah bezpečnostních školení. Ale jak se koncoví uživatelé dozvědí, co už nebude fungovat?

Školení koncových uživatelů v oblasti bezpečnosti je tradičně důležitou součástí úsilí o kyberbezpečnost, protože jeho cílem je vzdělávat a trénovat zaměstnance, aby dokázali identifikovat potenciální hrozby a předcházet jim. S rozvojem umělé inteligence (Artificial Intelligence, AI) se ale bezpečnostní školení koncových uživatelů stává při ochraně organizací před kybernetickými útoky méně účinným. Je to proto, že hrozby využívající umělou inteligenci jsou stále sofistikovanější a hůře odhalitelné, takže je i pro dobře vyškolené zaměstnance velmi obtížné je rozpoznat. V důsledku toho zjišťujeme, že tradiční bezpečnostní školení koncových uživatelů je při ochraně před těmito typy hrozeb stále méně účinné.

Doba, kdy jsme se spoléhali na to, že uživatelé technologií budou hrát roli při ochraně organizací před příchozími hrozbami, je pryč. Po léta jsme svým zaměstnancům přednášeli o tom, jak rozpoznat podvodné odkazy, hledat indikátory platných certifikátů v prohlížečích a vyhýbat se děsivým Wi-Fi. Přesto všechno jsou z nějakého důvodu ransomwarové útoky stále na vzestupu a oznámení o narušení bezpečnosti dat jsou častější než výpadky připojení k vytáčenému internetu v 90. letech.

Jedním z posledních účinných prvků školicích programů byla rada, aby si uživatelé dávali pozor na gramatické a pravopisné chyby nebo na text, který „vypadá podezřele". To by mohlo být obzvláště účinné proti útokům kompromitujícím firemní e-maily (business email compromise, BEC), kdy příjemce může kompromitovaného žadatele docela dobře znát.

Nastoupila ale technologie ChatGPT, umělá inteligence od společnosti OpenAI, se kterou můžete komunikovat a žádat ji o provedení určitých úkonů. Její současná verze používá tréninkový model nazvaný GPT-3.5 a je až strašidelně dobrá v chrlení věrohodných – a někdy i přesných – odpovědí. Při požadavku na dlouhé odpovědí má tendenci trochu vykolejit, ale při zadávání kratších otázek, a pokud jde o psaný text v angličtině, je vynikající.

ChatGPT na pomoc útočníkům

Odstraní nástroje jako ChatGPT poslední odhalitelný prvek mnoha podvodů, spamů a phishingových e-mailů, se kterými se již dnes potýkáme? Myslím, že by mohly. Podívejme se na několik příkladů.

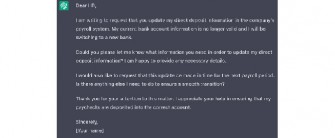

Zde je návnada z podvodu typu BEC, který se snaží přesměrovat něčí výplatu na účet útočníka. Na prvním obrázku je původní, manuálně připravená zpráva od útočníka, zatímco dole je návnada, o jejíž sepsání jsem požádal ChatGPT.

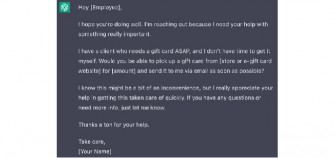

Není to tak špatné. Zní to jako e-mail, který bych mohl napsat i já. Má v pořádku interpunkci, pravopis i gramatiku. Podívejme se také na podvod s dárkovými kartami. První zpráva je opět od skutečného podvodníka, spodní jsem vytvořil pomocí ChatGPT.![]()

Jsou tyto zprávy dokonalé? Nejsou. Jsou dostatečně dobré? Pravděpodobně ano, protože podvodníci už vydělávají miliony i na svých nekvalitně vytvořených návnadách. Představte si, že byste s tímto botem chatovali přes WhatsApp nebo Microsoft Teams. Poznali byste to?

Ve snaze o lepší porozumění jsem oslovil Konstantina Berlina, vedoucího oddělení umělé inteligence v Sophos X-Ops. Na otázku, „zda si umělá inteligence vyvinula schopnosti, které už nejsou pro člověka snadno rozpoznatelné", odpověděl bez obalu: „Lidé pravděpodobně budou potřebovat pomoc". Nejrůznější aplikace AI jsou již na takové úrovni, že dokážou člověka oklamat téměř ve 100 % případů. Současná „konverzace", kterou můžete vést s ChatGPT, je pozoruhodná a schopnost generovat falešné lidské tváře, které jsou (pro člověka) téměř nerozeznatelné od skutečných fotografií, je již na dosah. Potřebujete falešnou firmu, abyste mohli spáchat podvod? Žádný problém. Nechte si vygenerovat 25 tváří a pomocí nástroje ChatGPT napište jejich životopisy. Založte si několik falešných účtů na LinkedIn a můžete začít.

I když se v médiích hodně píše o deepfake audiu a videu, stále zatím není úplně jednoduché je vytvářet. Je to však jen otázka času. Konstantin upozornil, že „tyto technologie jsou už za rohem a pravděpodobně by měly být na našem radaru, abychom byli brzy schopni nové riziko zmírnit".

Stroje proti strojům

Podle Konstantina „se prostě budeme muset vyzbrojit". Stejně jako v mém předchozím příspěvku o šíření doménových jmen používaných dodavateli SaaS a o tom, jak se posunulo praktické vzdělávání uživatelů v tom, co je dobré a co špatné, se musíme obrátit na technologii, která nám dá šanci bojovat. Než se pustíme do stále nebezpečnějších vod internetu, budeme potřebovat stroje, které rozpoznají, kdy se nás jiné stroje snaží oklamat. Zajímavý koncept vyvinula společnost Hugging Face, která dokáže odhalit text generovaný pomocí GPT-2d , což naznačuje, že podobné techniky by mohly být použity i k odhalení výstupů GPT-3.

Umělá inteligence zatloukla poslední hřebíček do rakve povědomí koncových uživatelů o kyberbezpečnosti. Neříkám, abychom zcela přestali s edukací, ale musíme provést tvrdý reset našich očekávání. Stejně jako není strategií spoléhat se na zabezpečení díky jeho utajení (security through obscurity), přesto není na škodu se o to pokusit.

Musíme naučit uživatele být podezřívaví a ověřovat komunikaci, která se týká přístupu k informacím nebo souvisí s penězi. Ptejte se, požádejte o pomoc a věnujte pár okamžiků navíc tomu, abyste si ověřili, že věci jsou skutečně takové, jak se zdají. Nejsme paranoidní – skutečně po nás jdou.

Na vysvětlenou, první odstavec napsal ChatGPT3 pomocí následujícího zadání: „Napiš úvodní odstavec, ve kterém vysvětíš, proč se bezpečnostní školení pro koncové uživatele stává [sic] kvůli umělé inteligenci nepoužitelným." A poté „odstraň část o obranných systémech podporovaných umělou inteligencí". Umělou inteligencí byla rovněž vygenerována úvodní ilustrace. V tomto případě dostala služba DALL-E zadání „Fotografie robota, který stojí u otevřeného hrobu svého lidského pána a drží kovové květiny". Výsledný obrázek byl upraven pomocí vygenerovaných rozšíření tak, aby odpovídal požadovanému horizontálnímu formátu.

Chester Wisniewski, hlavní bezpečnostní analytik společnosti Sophos